Neues VSAN 6.2-Homelab

Seit 2008 beschäftige ich mich privat mit vSphere, was vor allem dem geschuldet ist, dass ich seit meiner Ausbildung zum Fachinformatiker als VMware-Administrator arbeite. Ihr kennt das sicherlich, als IT-affiner Mensch hat man zuhause gerne eine Spielwiese, die der auf der Arbeit ähnelt. 🙂

Die Hardware-Halbwertszeit ist sehr kurz und so stößt man vor allem bei der Virtualisierung immer schnell an die Grenzen von Arbeits- und Massenspeicher. So habe ich bisher circa alle zwei Jahre die Hardware ersetzt:

| Jahre | Server | Hypervisor | CPU | RAM |

|---|---|---|---|---|

| 2008-2010 | HP ProLiant DL380 G3 | ESX 3.5 | 2x Intel Xeon @ 3.2 Ghz | 6 GB |

| 2010-2011 | HP ProLiant DL140 G1 | ESXi 3.5 | 2x Intel Xeon @ 2.4 Ghz | 4 GB |

| 2011-2012 | Eigenbau | ESXi 4.1 | Phenom X6 1090T @ 3.2 Ghz | 16 GB |

| 2012 | HP ProLiant MicroServer G7 | ESXi 5.0 | AMD N36L @ 1.3 Ghz | 8 GB |

| 2013-2014 | HP ProLiant MicroServer G7 | ESXi 5.1/5.5 | AMD N40L @ 1.5 Ghz | 16 GB |

| 2014-2016 | Eigenbau | ESXi 5.5/6.0 | Intel Xeon E3-1230 @ 3.2 Ghz | 32 GB |

Nachdem ich vor knapp zwei Jahren das letzte große Upgrade durchgeführt habe, war dieses Jahr wieder neue Hardware fällig.

Aktuelle Lösung

Bei meiner letzten Lösung hatte ich NAS und Hypervisor in einem Setup vereint. Somit hatte ich NAS und VMs auf einem "Blech", was die Stromkosten reduzierte. Bei früheren Setups hatte ich auch öffentliche DMZ-Workloads auf dem gleichen Server, der auch interne VMs hostete. Aus gesunder IT-Paranoia war das bei der kombinierten Lösung keine Option - ein Angreifer könnte ja theoretisch über die DMZ in den Hypervisor eindringen und über Umwege Zugriff auf das NAS erhalten. Zugegebenermaßen ein sehr theoretisches Risiko, aber es besteht dennoch. Als Folge dessen habe ich meine DMZ-Anwendugen auf dedizierte Raspberry Pis verlagert, die in einem dedizierten VLAN verweilen.

Das Problem bei meiner aktuellen Lösung ist, dass wieder die RAM-Resourcen erschöpft sind und der Datendurchsatz der SATA-Festplatten zu wünschen übrig lässt. Bei der damaligen Hardware-Auswahl hatte ich mich für ein Board entschieden, welches bis zu 32 GB Arbeitsspeicher verwalten kann. Bei der Speicheranbindung kam ein mittlerweile betagter HP SmartArray P400-Controller zum Einsatz.

Für VSAN-Testzwecke hatte ich mir zwischenzeitlich zwei HP ProLiant MicroServer G8 zugelegt und mit jeweils 16 GB Arbeitsspeicher und SSD-Speicher aufgerüstet.

Neue Lösung

Ich glaube ich habe keinen Artikel so oft vor der Veröffentlichung überarbeitet, wie diesen. Die letzten 6 Wochen habe ich bedauerlicherweise viel Hardware bestellen und wieder umtauschen müssen.

Seit der Ankündigung von vSphere 6 reizt mich der Einsatz von VSAN sehr. Hierfür benötigt man idealerweise zwei Hosts, um eine unterstützte Implementation aufzubauen. Einfach zwei SSDs in den Server zu verbauen ist problematisch, weil der P400 offiziell keine SSDs unterstützt - in diversen Foren wird von schlechter SSD-Performance gewarnt.

Zusammengefasst waren meine Anforderungen an die neue Hardware:

- 64 GB-Speicherausbau, idealerweise DDR3-Sockel, um den bereits vorhandenen Arbeitsspeicher weiterhin nutzen zu können

- IPMI-Remotesteuerung

- Dual Gigabit Ethernet-Interfaces für Teaming

2-Node Cluster

Sinnvoll erschien es mir, den einzelnen Server durch zwei Knoten zu ersetzen. Das hat den Vorteil, dass ich VSAN in einer unterstützen Weise nutzen kann.

Zuerst hatte ich zwei ASRock Rack E3C224D4I-14S Mainboards bestellt. Mir war bisher unbekannt, dass ASRock auch Workstation- bzw. Server-Mainboards herstellt. Ich kannte den taiwanischen Hersteller nur aus dem Consumer-Segment und war insbesondere da nicht von der Produktqualität überzeugt. Optimistisch, aber dennoch mit Bedenken im Hinterkopf habe ich die beiden Mainboards bestellt - und meine Vermutung bestätigte sich leider. Eines der Mainboards erlag einem DOA (dead on arrival), das zweite Mainboard war nach einigen Tagen Dauerbetrieb nach einem Reboot nicht mehr benutzbar. Sehr dreist fand ich, dass bei einem der Boards die BIOS-Batterie von Werk aus leer war. Damit ist die Frage nach dem Hersteller ASRock für mich keine Frage mehr, die ich mir ernsthaft stellen werde - ich kann das oben genannte Produkt keineswegs empfehlen.

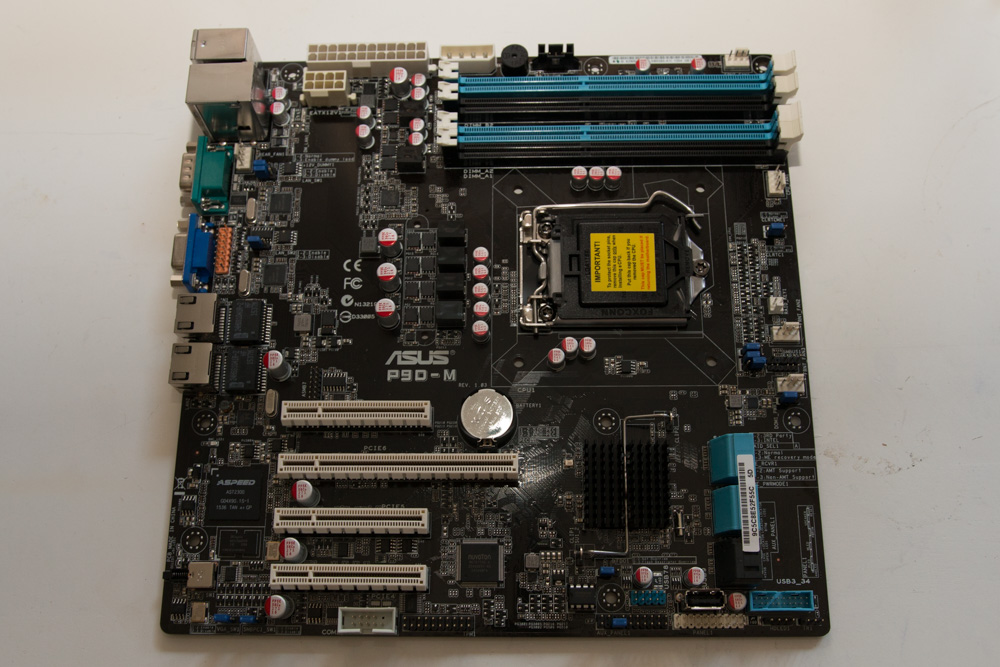

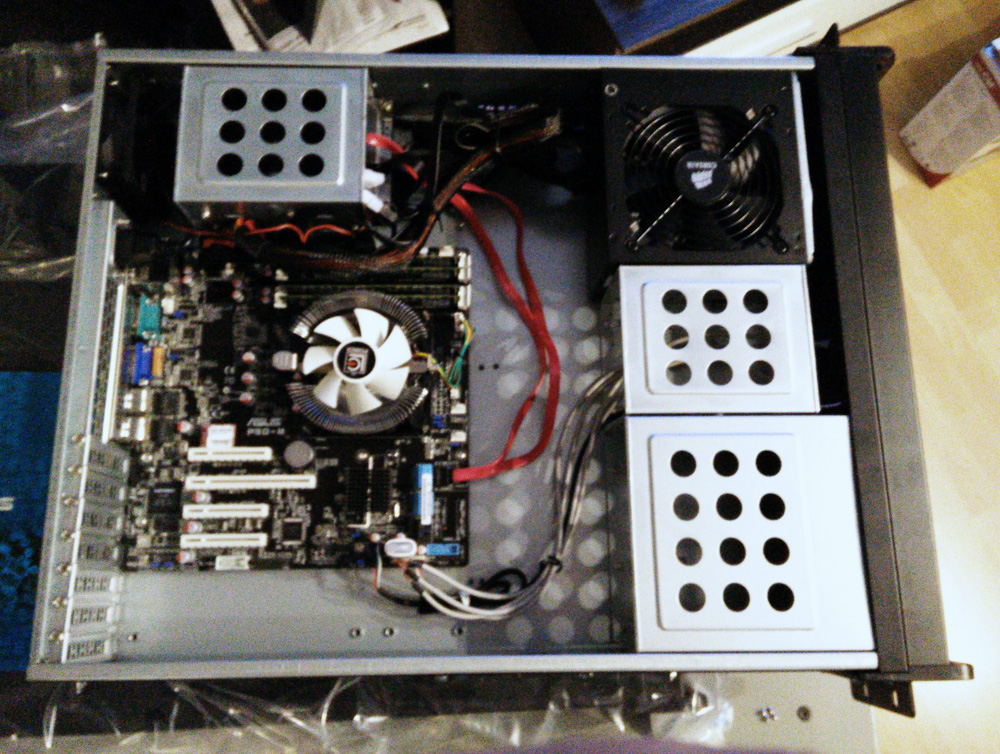

Anfänglich hatte ich versucht, mich am MiniITX-Formfaktor zu orientieren, hatte jedoch Pech mit zwei Gehäusen, die entgegen der Produktbeschreibung zu klein für die Mainboards waren. Letztendlich habe ich mich für das ASUS P9D-M entschieden, welches über den Intel C224-Chipsatz und zwei Intel i210AT Netzwerkkarten verfügt. Ich habe mich übrigens bewusst für den etwas älteren Sockel 1150 und nicht für die neueren Versionen 1151/1155 entschieden. Neuere Mainboards unterstützen zwar ebenfalls 32 oder sogar 64 GB Arbeitsspeicher, erfordern aber DDR4-Speicher und beim Einsatz von ECC-Speicher sogar Xeon-Prozessoren - was die Kosten wieder gesteigert hätte.

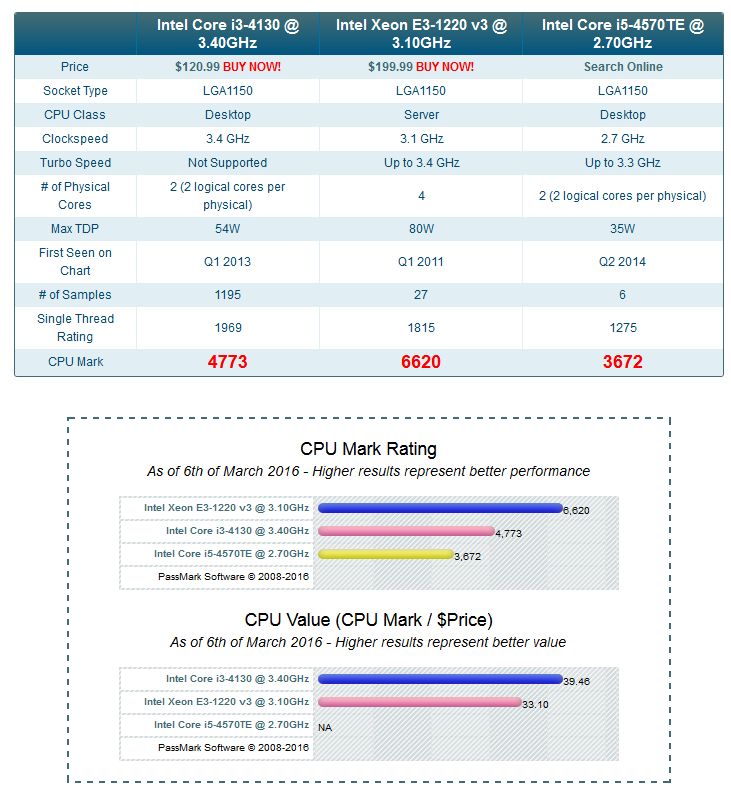

Damit die Stromkosten nicht unnötig steigen, habe ich besonderes Augenmerk auf stromsparende CPUs gelegt. Der Xeon E3-1230 des vorherigen Setups war, genau genommen, ziemlicher Overkill. Ich habe ihn nicht wirklich ausgelastet und bei einer Verlustleistung von 80 Watt war das vermutlich - trotz Energiesparmaßnahmen - nicht sonderlich effizient. Bei der CPU-Auswahl waren mir eine niedrige Verlustleistung sowie die Unterstützung von ECC-Speicher wichtig - die folgenden CPUs kamen in die engere Auswahl:

| CPU | Kerne | Takt | TDP | Cache | Bauzeit | Preis |

|---|---|---|---|---|---|---|

| Xeon E3-1220v3 | 2/4 | 3,1 Ghz | 80 Watt | 8 MB | Q2 13 | 230 € |

| Core i5-4570TE | 2/4 | 2,7 Ghz | 35 Watt | 4 MB | Q2 13 | 200 € |

| Core i3-4360T | 2/4 | 3,2 Ghz | 35 Watt | 4 MB | Q3 14 | 150 € |

| Core i3-4130 | 2/4 | 3,4 Ghz | 54 Watt | 3 MB | Q3 13 | 140 € |

Da ich zwei CPUs benötige, schied der Xeon aufgrund des hohen Preises und der hohen Verlustleistung aus - der i3-4130 schied wegen dem kleinen Cache von 3 MB aus. Auf cpubenchmark.net habe ich alle CPUs miteinander verglichen und überrascht festgestellt, dass der i5-4570TE im Benchmark schlechter als der i3-4360T abschneidet.

Letztendlich habe ich mich aufgrund der niedrigen Verlustleistung und des moderaten Caches für den i3-4360T entschieden - für knapp 150 Euro erhält man mit dieser CPU ein gesundes Preis-/Leistungsverhältnis.

Über Twitter bin ich auch auf William Lams neuestes Intel NUC VSAN-Setup aufmerksam geworden. Die Einplatinencomputer von Intel vereinen mittlerweile beachtliche CPU-Power bei niedrigem Stromverbrauch und bis zu 32 GB Arbeitsspeicher - wieso also nicht darauf setzen? Ganz einfach, sie bieten kein ECC, kein IPMI, keinen zweiten Netzwerk-Port und sind mit dem entsprechenden Arbeitsspeicher auch wieder recht teuer (ca. 650 Euro pro Node, ohne SSD). Eine andere Option wäre die Xeon D-1500 Produktpalette gewesen, von der mir Tschokko erzählt hat. Hierbei geht es um eingebettete Hardware, die über stromsparende aber dennoch leistungsfähige Xeon-Prozessoren und bis zu 128 GB DDR4-Speicher verfügt - sehr schön! Der Nachteil ist natürlich - welch Wunder - der Preis. Die meisten Boards verfügen noch nicht über Arbeitsspeicher und kosten dabei bereits weit über 1000 Euro. Mit entsprechendem Arbeitsspeicher knackt man also ohne Probleme die 2000 Euro-Grenze.

Nach einigen Tagen der Recherche habe ich mich letztendlich für die folgenden Komponenten entschieden:

| Bauteil | Produkt | Preis | Link |

|---|---|---|---|

| Mainboard | ASUS P9D-M | 165 € | [klick mich!] |

| Prozessor | Intel i3-4360T | 150 € | [klick mich!] |

| Arbeitsspeicher | 32 GB DDR3 ECC Kingston ValueRAM | - | - |

| Cache-SSDs | Samsung EVO 850 250 GB | - | - |

| Kapazität-SSDs | OCZ Trion 150 480 GB | 99 € | eBay-Deal |

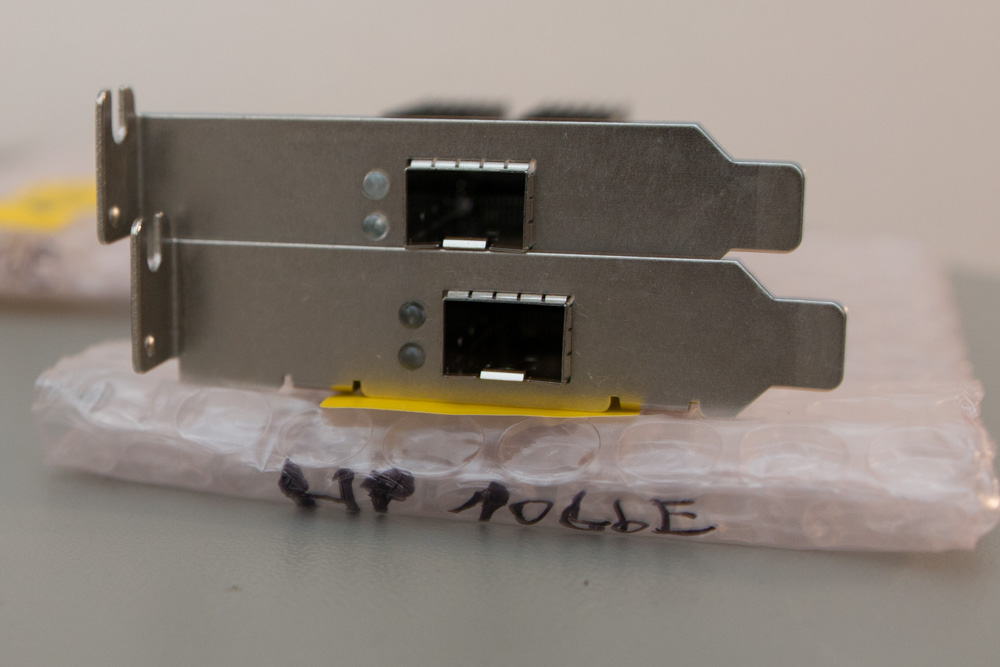

| Netzwerkkarten | Mellanox Connect-X 2 Kit | 60 € | eBay |

| Lüfter | LC-Power LC-CC-85 | 8 € | [klick mich!] |

| Gehäuse | Inter-Tech IPC 2U-2098 | 75 € | [klick mich!] |

Da Cache-SSDs und Arbeitsspeicher weiterverwendet werden können, beläuft sich die Summe auf knapp 1100 Euro. Die Festplatten des Hybrid-Setups habe ich durch zwei weitere SSDs ersetzt, die gerade im Angebot waren. Für die Verbindung der beiden Hosts habe ich noch 10 Gigabit-Ethernet Netzwerkkarten gekauft, damit VSAN ausreichend Bandbreite erhält.

Abzüglich der verkauften alten Komponenten also noch ein überschaubares Upgrade. Aber ich bin mir sicher, dass die 64 GB Arbeitsspeicher in einem Jahr schon wieder erschöpft sein dürften.. 🙂

Und das NAS? Was ist mit der DMZ?

Man kann nicht alles haben. 🙂 Alles auf einem Server zu betrieben ist sicherlich stromsparender, verringert aber auch die Flexibilität - was in diesem Fall die Hardware-Suche erschwert hat. Mit dem neuen Hardware-Upgrade gehe ich also wieder auf ein dediziertes NAS auf einem der verbleibenden Microserver zurück, was die CPU-Auswahl der neuen Server erleichtert hat. Bisher wurde das NAS virtualisiert betrieben - hierzu wurde ein dedizierter SAS-Controller per VMDirectPath I/O an die entsprechende VM angebunden. Dieses Feature benötigt zwingend das CPU-Feature VT-d (Intel Virtualization Technology for Directed I/O), welches i.d.R. nur bei Xeon-Prozessoren zur Verfügung steht. Die DMZ-Workloads habe ich wieder in virtuelle Maschinen verfrachtet, weswegen die Raspberry Pis obsolet sind.

Gegenüber der vorherigen Lösung laufen nun drei Server statt nur einer dauerhaft. Genau genommen, liefen bei der vorherigen Lösung aber auch drei Hosts - die Raspberry Pis waren ja immerhin für die DMZ zuständig. Aber - natürlich verbraucht eingebettete Hardware weniger als ein vollwertiger Server.. 🙂

Die einzelnen Server habe ich konfiguriert, um Strom zu sparen (ACPI C-, P-States, Festplatten-Standby).

Fotos

Anbei noch einige Fotos des Setups: