Red Hat Summit 2023

Vom 23.05 bis zum 25.05 fand die Red Hat Summit in Boston statt. Die herstellereigene Konferenz fand damit - aus bekannten Gründen - erstmals seit 2020 wieder in Präsenz statt. Für mich war es die erste Red Hat-Konferenz.

Anlässlich der Red Hat Summit 2023 wurde im FOCUS ON: Linux-Podcast ein dreiteiliges Special veröffentlicht. Neben einem Wrap-Up gibt es auch Interviews zu oVirt und RHEL sowie UX und Fedora.

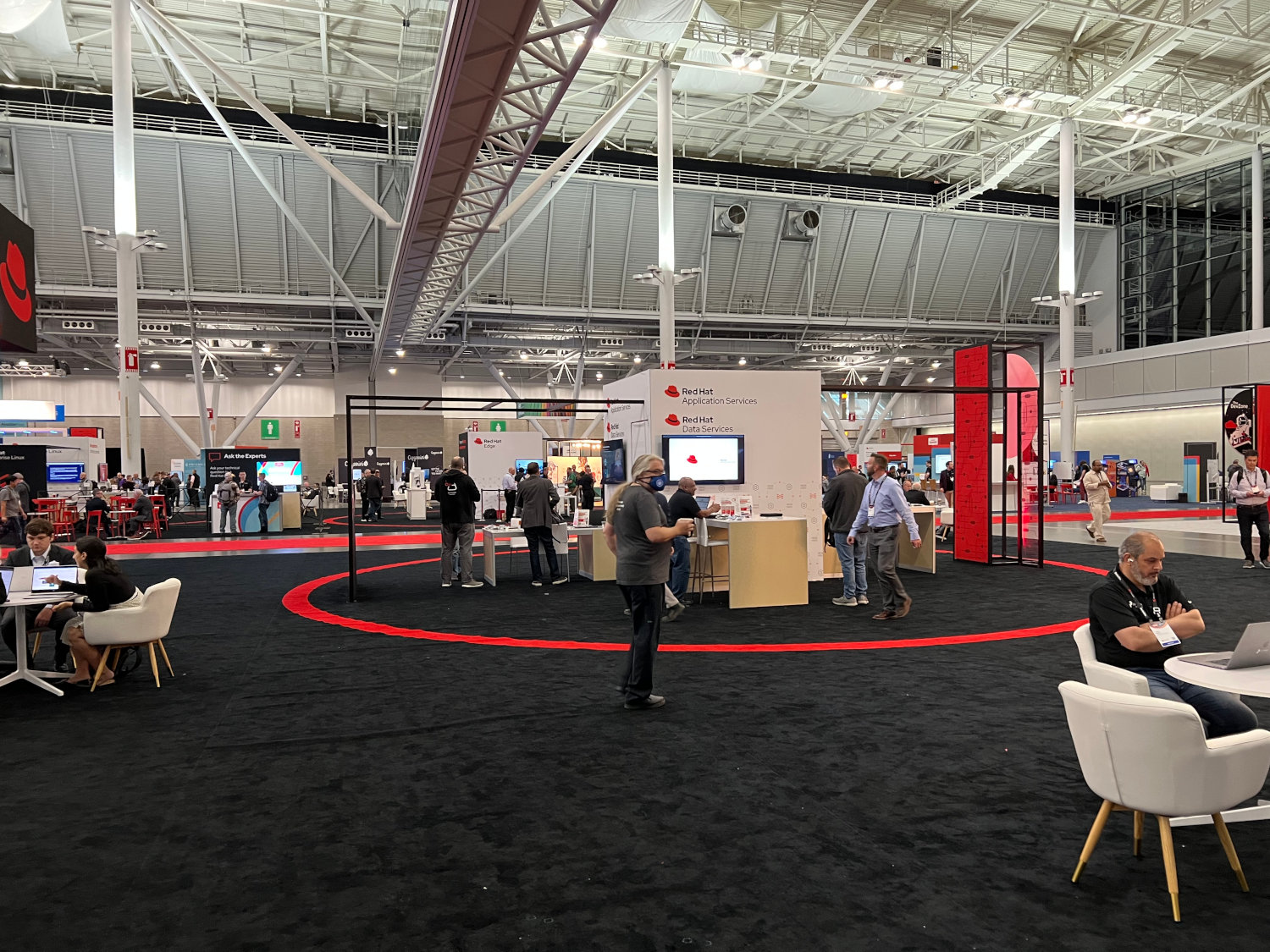

Location

Das Event fand im Boston Convention & Exhibition Center statt. Mit knapp 5 Hektar Größe bietet die Location enorm viel Platz, der für die angebotenen 350 Vorträge und Workshops sowie die zahlreichen Hands-On-Labs auch benötigt wurde. Es ist sehr leicht sich zu verlaufen - die angebotene Red Hat Event Guide-App ist zwingend notwendig, um den Überblick zu behalten. Es ist auch definitiv empfehlenswert vor Konferenzbeginn die gewünschten Vorträge im Kalender einzupflegen - auch aus logistischen Gründen. Besonders beliebte Vorträge waren schon vor dem Kickoff ausgebucht.

Ebenfalls schnell vergriffen war das Merchandising im Cool Stuff Store - hier hat sich der Einkauf gelohnt, wenn man schnell genug war. Die angebotenen Artikel kann man zwar auch online bestellen, muss hier aber hohe Versand- und Zollkosten einkalkulieren. Im Ausstellungsbereich gab es neben Community-Ständen (u.a. Ansible, Foreman, Fedora) auch zahlreiche Hersteller, die Fragen beantworteten und neue Produkte vorstellten.

An einem der Red Hat Community-Stände wurden Bücher signiert. Ein Kollege und ich hatten das Glück die letzten zwei Exemplare von Daniel Walsh' Buch "Podman in Action" zu bekommen und einige Worte mit ihm zu wechseln.

Keynotes

Gleich in der ersten Keynote "Innovation doesn’t rely on your IT budget" wurde das Hauptthema der Konferenz gesetzt: AI.

Matt Hicks (Präsident und CEO) gab an, künstliche Intelligenz habe sich von einer Spielerei zu einer allgegenwärtigen Technik entwickelt. Innovative Lösungen erlauben weitere Zeitersparnis und haben eine komplett neue Branche mit Momentum erschaffen. Neben Ansible soll bei Red Hat vor allem auch OpenShift von speziell trainierten Modellen profitieren, um den Zugang zur Technologie zu erleichtern. Mit Ansible Lightspeed, OpenShift AI und OpenShift Data Science wurden gleich drei Zusatzprodukte vorgestellt, die sich derzeit in Entwicklung befinden.

GitHub Copilot-Anwender:innen dürften gewisse Parallelen bei der Ansible Lightspeed-Demo entdeckt haben, denn Lightspeed vervollständigt ebenfalls Kommentare zu einsatzfähigem Code. Gegenüber Copilot oder GPT dürfte jedoch mit einer höheren Code-Qualität zu rechnen sein, da das Trainingsmaterial von Red Hat ausgewählt und nicht blindlinks öffentlicher Code aus dem Internet verwendet wurde (wir wissen alle, wie gut dieser ist 🙄).

OpenShift AI stellt die Infrastruktur auf Basis von OpenShift bereit, die für das Trainieren und Ausführen von AI- und Machine Learning-Modellen benötigt wird. Neben Cloud-Umgebungen sollen auch Edge- und Airgapped-Szenarien unterstützt werden. Mit Partnern vortrainierte Modelle sollen den Einstieg vereinfachen - hier muss lediglich ein Feintuning stattfinden. Ca. 30 Partnerunternehmen zählen derzeit zu Red Hats AI-/ML-Ökosystem. Chris Wright (CTO and Senior VP, Global Engineering) präsentierte stolz eine erste Customer Success Story des deutschen IT-Dienstleisters Atruvia. Dieser bewegt sich vor allem im Bankensektor und setzt die Technologie bereits ein.

OpenShift Data Science soll vor allem Data Scientists dabei helfen, sich besser auf die Entwicklung zu fokussieren. Hierzu soll die übliche OpenShift-Komplexität (YAML, Helmcharts) entfallen. Das für Hybrid Clouds konzipierte Produkt erleichtert das Bereitstellen supporteter Sandbox-Umgebungen für das Entwickelen, Trainieren und Testen von Machine Learning-Modellen drastisch. Als Addon konzipiert, kann es per Mausklick einfach installiert werden.

Über ein Dashbord können verschiedene unterstützte Werkzeuge, wie beispielsweise JupyterHub, OpenShift Streams for Apache Kafka oder IBM Watson Studio bereitgestellt werden. Alle dafür benötigten technischen Details (Deployment, Ressourcen, etc.) werden komplett abstrahiert. Im Dashboard können zahlreiche Tutorials und Dokumentationen konsumiert werden. Das Produkt steht ab Ende Juni als Technology Preview zur Verfügung.

Auf YouTube findet sich eine Demonstration der Technologie.

Mit Red Hat Service Interconnect wurde ein auf Skupper basiertes Tool vorgestellt, welches zum Verbinden von Apps und Services über verschiedene Kubernetes-Cluster dient. Es arbeitet auf OSI-Layer 7 und benötigt weder VPNs noch spezielle Firewall-Regeln. Anders ausgedrückt: mit Skupper können sich Applikationen über mehrere Rechenzentren und Cloud-Provider erstrecken.

Die zweite Keynote "Optimize to innovate at scale" stand ganz im Licht der zahlreichen Partnerschaften, die Red Hat pflegt. So sprachen Stefanie Chiras (Senior VP, Partner Ecosystem Success, Red Hat), Ruba Borno (VP World Wide Channels and Alliances, AWS), Gene Reznik (Senior VP, Ecosystem and Industries, Celonis) und Todd Pavone (President, Strategic Partnerships, DELL Technologies) vor allem über gemeinsame Projekte und Herausforderungen.

Bedeutend interessanter und unerwarteter fand ich die Aufwertung von Red Hat Insights. Während das Tool bisher vor allem für proaktives Security-Monitoring (CVEs, Best Practices) stand, soll es in Zukunft einige Features aus dem Red Hat Satellite-Umfeld anbieten. So sollen sich in Kürze Hostgruppen und Patches einfach verwalten lassen. Der bisher nur über Cockpit verfügbare Image Builder soll dann auch als Service zur Verfügung stehen und Cloud-Images patchen und auch bereitstellen können. Die neuen Funktionen dürften vor allem kleinere Kund:innen erfreuen, die die Komplexität von Satellite scheuen und noch kein Deployment-Werkzeug, wie beispielsweise HashiCorp Terraform, einsetzen. Die Aufwertungen sollen erfreulicherweise allen RHEL-Subscriptionen zur Verfügung stehen.

In Summe fand ich die Keynotes interessant, auch wenn es meinem Geschmack nach auch etwas weniger AI hätte sein dürfen. Nicht falsch verstehen: aus technischer Perspektive sind die vorgestellten Tools sehr interessant und scheinen auch einen Mehrwert bieten zu können. Beim derzeit omnipräsenten AI-Hype steht die wichtige Frage nach der Effizienz und dem Prinzip der Abhängigkeit jedoch oftmals im Hintergrund. Ich persönlich sehe mich nicht dabei, meinen Ansible-Code zu großen Teilen von einem Sprachmodell generieren zu lassen. Keine Frage, IT hat eine Komplexität erreicht, in der man nicht mehr alle Technologien des Stacks verstehen kann, bei grundlegenden Komponenten - wie dem Configuration Management - fühle ich mich jedoch nicht gut dabei, von einer künstlichen Intelligenz abhängig zu sein.

Die Erneuerungen aus dem Event-driven Ansible- (siehe auch weiter unten) und Insights-Umfeld finde ich spannend und werde sie mir näher anschauen.

Ansible Lightspeed

Die wohl größte Ankündigung war Ansible Lightspeed (ehemals Project Wisdom). Hierbei handelt es sich um ein Projekt, bei dem IBM Watson Code Assistant um ein auf Ansible trainiertes Modell erweitert wurde.

Mithilfe einer VScode-Extension können beispielsweise Task-Beschreibungen automatisch um das gewünschte Verhalten ergänzt werden. Hierbei muss die Beschreibung in Englisch erfolgen - andere Sprachen werden derzeit nicht unterstützt. Die gezeigte Live-Demo war authentisch - in einem Hands-On-Lab konnte man sich davon überzeugen.

Weitere Informationen gibt es in der Dokumentation - auf der folgenden Seite gibt es Slides und ein Hands-On-Lab.

Der Service versteht sich als Technology Preview, für den man sich noch bis Ende Juni anmelden kann. Das Angebot kann in der Entwicklungsphase kostenlos genutzt werden, da Eingaben für weiteres Training benutzt werden. Es wird ein GitHub-Account benötigt.

Hier und hier gibt es weitere Labs zu Execution Environments und weiteren Entwicklungsthemen.

Molecule 6

Ich entwickle regelmäßig Ansible-Rollen und -Collections und benutze daher Molecule für automatisiertes Testen. Nachdem das Projekt nun seit einiger Zeit offiziell zur Ansible-Community gehört, sind für Molecule 6 größere Änderungen geplant.

Der Fokus soll zukünftig ganz auf Testing liegen, weswegen Breaking Changes zu erwarten sind. Geplant sind unter anderem besserer CI-/CD-Support sowie das automatische Generieren von Dokumentationen. Die Integration von testinfra entfällt, es kann nur noch der delegated-Treiber für Deployments genutzt werden. Die zentrale Konfigurationsdatei molecule.yml soll Ansible-Variablen weichen.

Das Tool soll mehr dem "Look and Feel" von Ansible entsprechen, ein VM-/Container-Deployment über Ansible soll jedoch weiterhin möglich sein. pytest-ansible und tox-ansible werden integraler Bestandteil der neuen Programmversion.

Derzeit versteht sich Molecule 6 als Developer Preview, im der für Q3 geplanten Ansible Automation Platform 2.4 soll das Tool stabil einsetzbar sein.

Event-driven Ansible

Ein weiteres, nicht mehr ganz brandneues Thema war Event-driven Ansible. Hier wird Ansible um eine proaktive Komponente erweitert. Während Ansible bisher reaktiv agierte und vor allem manuell oder in zeitlichen Abständen automatisch ausgeführt wurde (z. B. über AWX oder Ansible Automation Platform), kann Ansible so dynamisch auf Ereignisse reagieren.

Zentraler Bestandteil der Lösung sind sogenannte Rulebooks, in welchen zu überwachende Ereignisse definiert werden. Tritt ein solches Event ein, kann eine entsprechende Gegenmaßnahme definiert werden - i.d.R. das Ausführen von Ansible-Playbooks.

Für die Überwachung werden Plugins benötigt. Derzeit werden gerade 22 Plugins von 9 Partnern entwickelt, unter anderem:

- ServiceNow

- CyberArk

- F5

- Apache Kafka

- Prometheus/Alertmanager

Geht ein Event ein, wird dieser an Ansible Automation Platform weitergeleitet. Dort gibt es eine entsprechende Serverkomponente, die dann Gegenmaßnahmen auslöst (Rulebook Engine). Diese Komponente wird als Gegenstück zum Execution Environment in ein sogenanntes Decision Environment ausgelagert. Somit existiert ein weiterer Container, der entsprechend skaliert werden kann - beispielsweise um die Verfügbarkeit zu erhöhen.

Rulebooks werden ebenfalls in YAML definiert - ein Beispiel:

1---

2- name: Webserver im Fehlerfall neustarten

3 hosts: all

4 sources:

5 - name: Auf Alarme lauschen

6 ansible.eda.alertmanager:

7 host: 0.0.0.0

8 port: 8000

9 rules:

10 - name: Webserver neustarten

11 condition: event.alert.labels.job == "fastapi" and event.alert.status == "firing"

12 action:

13 run_playbook:

14 name: ansible.eda.start_app

15...

Während einer der Keynotes wurde eine Demo mit Dynatrace gezeigt. Das Feature soll noch im Juni 2023 veröffentlicht werden.

Ich persönlich finde das Feature für einige Szenarien sehr interessant - beispielsweise, wenn "selbstheilende Infrastruktur" benötigt wird. Bisher war diese Funktionalität ein Alleinstellungsmerkmal der konkurrienden IaC-Software SaltStack.

Weitere Informationen finden sich im Ansible-Blog, im GitHub-Repository sowie der Dokumentation.

Networking

Der Hauptgrund warum ich Konferenzen besuche ist Menschen zu treffen, die man sonst nicht treffen kann. Bei internationalen Konferenzen ist es sehr vorteilhaft, mal in der gleichen Zeitzone zu sein. Networking ist wichtig und ich hatte viel Spaß dabei neue Kontakte zu knüpfen und virtuelle Bekanntschaften erstmalig in die physische Realität zu holen.

So hatte ich die Gelegenheit endlich mal mit Carol Chen (Ansible Community Architect) zu sprechen - ein sehr nettes Gespräch! 😀

In der Red Hat Event Guide-App konnte man sich basierend auf Themen mit neuen Kontakte verabreden - über die auf den Teilnahmebadges aufgedruckten QR-Codes ließen sich auch kurzerhand Kontaktdaten austauschen.

Sehr erfreut hat es mich auch, mit Eric "The IT Guy" Hendricks, Máirín Duffy und Matthew Miller sprechen zu können. Eric ist u.a. als Gründer des Sudo Show-Podcasts und Host des Fedora-Podcasts bekannt.

Máirín ist als Senior Principal Interaction Designer der kreative Kopf hinter vielen Artworks und UX-Arbeiten im Red Hat-Ökosystem. So hat sie u.a. die Logos von Podman, Podman Desktop, Buildah und Skopeo gestaltet und auch die unterhaltsamen Coloring Books (SELinux, Container, Container Commandos, Reliability Nightmares) illustriert.

Matthew ist der Projektleiter des Fedora-Projekts. Als täglicher Fedora-Benutzer war es für mich sehr interessant sich mit ihm über die aktuellen und zukünftigen Entwicklungen auszutauschen.

Mit Máirín und Matthew konnten wir im nahegelegenen Red Hat-Office Interviews führen - eine sehr spannende Erfahrung, an die ich mich lange erinnern werde.

Ein kleines Museum im Büro war mein persönliches Highlight. Hier finden sich verschiedene historische Red Hat-Produkte und Merchandise, wie z. B. T-Shirts, Bücher und Sticker - es gab so viel zu entdecken. Eines der Shirts und die Red Hat Linux 6.1 Deluxe-Box besitze ich sogar auch! 😀

Boston

Wenn einem nach stundenlangen Vorträgen und Workshops nach Abwechslung ist, ist es sehr empfehlenswert Boston zu erkunden. Die Stadt wirkt sehr europäisch, was vor allem Reisenden gefallen dürfte, die noch nie zuvor in den USA waren. Boston ist eine der ältesten Groß- und Hafenstädte der USA und verfügt über ein großes Kultur- und Unterhaltungsangebot.

Die Stadt ist fußläufig erkundbar, der Freedom Trail zeigt 16 Sehenswürdigkeiten der Stadt und ein guter Einstiegspunkt, um einen groben Überblick zu bekommen. Hier sollte man auch unbedingt den Quincy Market besuchen - ein historisches Gebäude, in dem üblicherweise ein Food Market zu finden ist. Abends laden die Docks zu Spaziergängen ein, bevor man den Tag in einer der unzähligen Bars ausklingen lassen kann.

Wenn es die Zeit zulässt, ist es empfehlenswert mit einem Leihwagen die nördlich gelegene Halbinsel Cape Cod zu erkunden. Hier gibt es zahlreiche malerische Hafenstädte mit schönen Stränden - beispielsweise Provincetown. Alternativ liegen ca. 6 km von Boston entfernt die Campus der Harvard University und des Massachusetts Institute of Technology.